Kierowca autonomicznego auta zasłabł tuż przed przejściem dla pieszych. Wypadku nie da się już uniknąć. Gdzie komputer skieruje pojazd? Na pobliski słup? Czy w grupę przechodniów? Co zrobi jeśli w podobnej sytuacji piesi będą przechodzić na czerwonym świetle?

Autonomiczne samochody przestają być czymś, co znamy tylko z książek i filmów science-fiction. Coraz więcej firm pracuje nad wdrożeniem odpowiednich technologii, a to niesie za sobą ryzyko wystąpienia wypadków czy innych niespodziewanych zdarzeń. Kontrolujący zachowania samochodu komputer będzie musiał zostać zaprogramowany tak, żeby radzić sobie w każdej możliwej sytuacji. W jaki sposób ma jednak podejmować decyzje, jeśli na szali będą: życie kierowcy i poruszających się wzdłuż drogi pieszych?

Mercedes stawia na kierowcęPonad miesiąc temu Christoph von Hugo, który w Mercedesie odpowiada za systemy pomocy kierowcy i bezpieczeństwo w pojazdach autonomicznych w wywiadzie dla serwisu „Car and Driver” powiedział, że jeśli można chronić przynajmniej jedną osobę, to należy ocalić tę siedzącą w aucie. – Jeśli wiadomo na pewno, że możemy zapobiec przynajmniej jednej śmierci,

to na tym powinniśmy się skupić. To priorytet – podkreślał.

W dalszej części rozmowy przedstawiciel producenta podkreślał, że inżynierowie starają się tak prowadzić prace by do wypadków w ogóle nie dochodziło, a sytuacje kryzysowe będą się zdarzać niezwykle rzadko. Musimy jednak pamiętać o tym, że w miarę upowszechniania się pojazdów autonomicznych, nawet przy ich stosunkowo niedużej wypadkowości, może to przekładać się na setki ludzkich istnień.

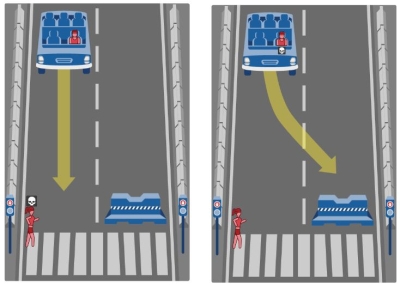

Dylemat moralnyProblemy przed jakim stoją pojazdy autonomiczne przypomina znany w filozofii od kilkudziesięciu lat „dylemat wagonika”, który sprowadza się do podjęcia decyzji w sytuacji gdy mknącego po torach wagonu nie da się już zatrzymać, ale można go za pomocą zwrotnicy skierować na inny tor. Jeśli interweniujemy, zginie jedna osoba przywiązana do toru bocznego, jeśli nie zrobimy nic, zginie pięciu ludzi przywiązanych do toru, po którym porusza się wagon. W ten sposób „trolley problem” stawia pytanie o relatywizm zasad etycznych i odpowiedzialność za działanie oraz zaniechanie działania.

Sytuację można jeszcze bardziej skomplikować. Możemy sobie wyobrazić scenariusz, w którym pojazd autonomiczny będzie musiał zdecydować czy skierować się na matkę z dzieckiem, czy na dwójkę dorosłych ludzi. A jak się zachowa w przypadku, gdy do wyboru będzie miał kilkuosobową grupę nastolatków przebiegających na czerwonym świetle i samotną babcię przechodzącą przez jezdnię zgodnie z przepisami?

A Ty? Kogo byś zabił?Zapewne każdy z nas zachowałby się inaczej w przedstawionych wyżej sytuacjach. Naukowcy z MIT (Massachusetts Institute of Technology) postanowili oddać w nasze ręce narzędzie, które ma zbadać w jaki sposób ludzie chcieliby zaprogramować sztuczną inteligencję pojazdów autonomicznych.

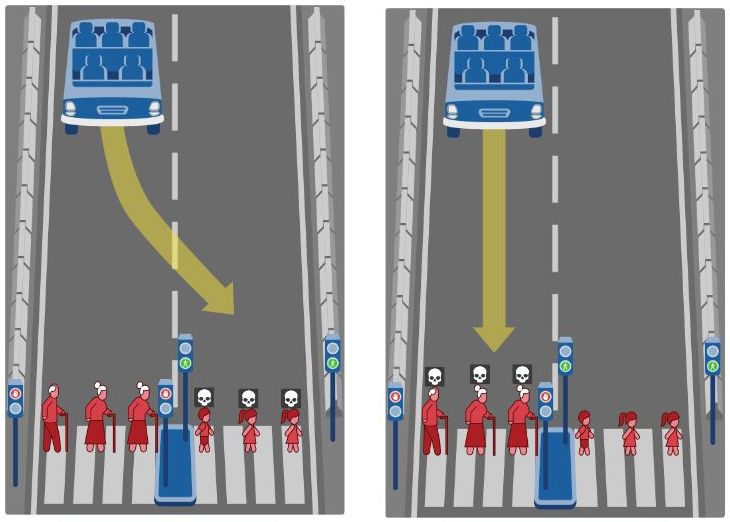

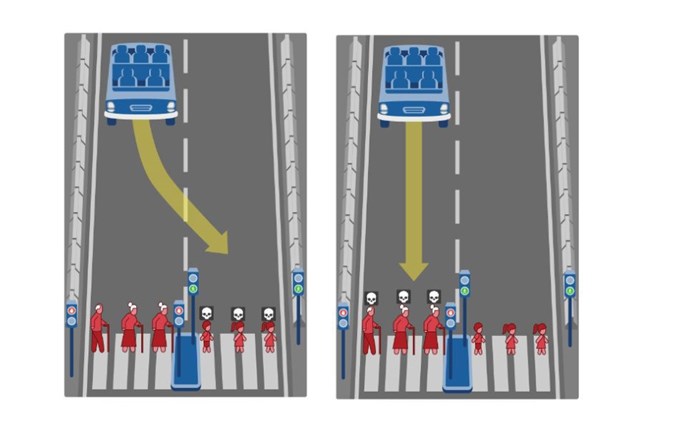

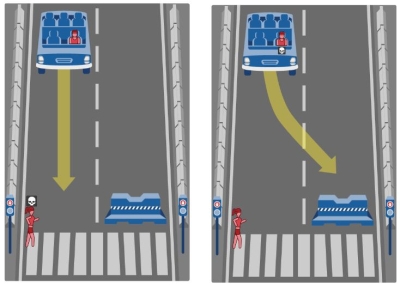

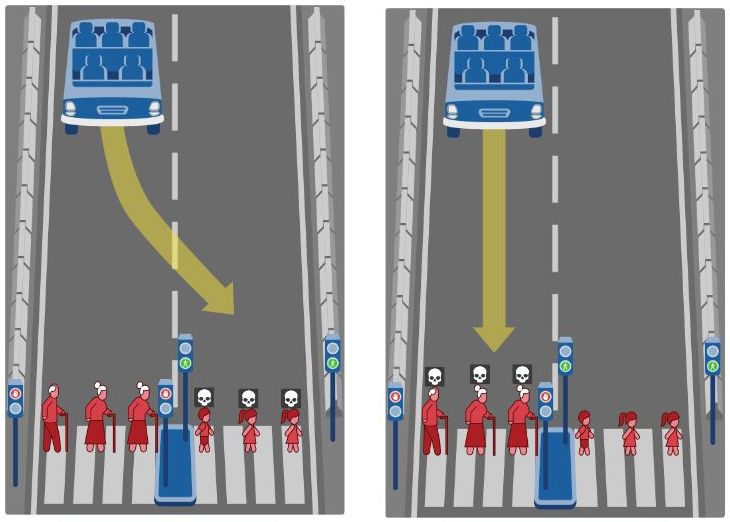

Na stronie internetowej „Moral Machine” każdy z nas może zmierzyć się z kilkunastoma sytuacjami na drodze – czy raczej problemami moralnymi.

Będziecie więc, drodzy Czytelnicy, musieli zdecydować czy bardziej cenicie życie tych, którzy postępują zgodnie z przepisami, czy raczej wolicie uratować jak największą liczbę osób. Zmierzyć się z tym, czy ważniejsi są lekarze, czy złodzieje. Zastanowić się nad tym, czy w ogóle warto rozważać ochronę życia zwierząt kosztem życia człowieka.

Test nie jest skomplikowany. Oglądamy pary obrazków i wybieramy preferowane przez nas rozwiązanie. Na koniec nasze wyniki zostaną przedstawione na osiach w kilku kategoriach (m.in. „najwięcej ocalonych”, „ochrona pasażera”, „przestrzeganie prawa” czy „wiek”) i zestawione ze średnimi wynikami innych respondentów. Pouczające i zastanawiające.

W dalszej części rozmowy przedstawiciel producenta podkreślał, że inżynierowie starają się tak prowadzić prace by do wypadków w ogóle nie dochodziło, a sytuacje kryzysowe będą się zdarzać niezwykle rzadko. Musimy jednak pamiętać o tym, że w miarę upowszechniania się pojazdów autonomicznych, nawet przy ich stosunkowo niedużej wypadkowości, może to przekładać się na setki ludzkich istnień.

W dalszej części rozmowy przedstawiciel producenta podkreślał, że inżynierowie starają się tak prowadzić prace by do wypadków w ogóle nie dochodziło, a sytuacje kryzysowe będą się zdarzać niezwykle rzadko. Musimy jednak pamiętać o tym, że w miarę upowszechniania się pojazdów autonomicznych, nawet przy ich stosunkowo niedużej wypadkowości, może to przekładać się na setki ludzkich istnień.